SEO Rankingfaktoren und Tugenden

Johannes Beus machte kürzlich auf einen Reddit-Thread von Gary Illyes aufmerksam. Darin behauptet der Google-Webmasterbeauftragte unter anderem, dass die Google-Algorithmen viel einfacher seien als vielfach vermutet. Meine erste Reaktion war: „Klar, es gibt eben einen großen Unterschied zwischen: Was Google könnte … und Was Google macht …“. Im Folgenden daher einige Worte über meine Sicht auf den Google-Algo und die Rankingfaktoren. Es ist – so glaube ich – tatsächlich vieles viel einfacher als man denkt. Mein letzter Artikel zu dem Thema ist über ein Jahr alt – und war zugegeben verwirrend :-)

Im Folgenden geht es nur um SEO für die „organische Websuche“ von Google. Also keine Bildersuche, News, Knowledge-Graph, Answerbox, Videos etc.

Ein Großteil des Google-Algorithmus ist sicherlich damit beschäftigt, jeweils zu entscheiden, welche dieser vertikalen Antwort-Optionen zusätzlich eingeblendet werden sollten. Das lasse ich hier einfach mal weg …

Es geht also nur um die organischen Suchergebnisse, die mit Title, Description und URL eingeblendet werden. Welche Rankingfaktoren sind für diese Ergebnisse denn tatsächlich wichtig? Ohne Frage ist das Wichtigste der Inhalt der Seite. Denn Google will logischerweise, dass der Benutzer auch tatsächlich das Gesuchte findet (gute „Nutzer-Erfahrung“).

Relevanz der Seite

Rankingfaktoren sind Signale einer Website, die Google für jede Website messen und statistisch abspeichern kann (quantitativ und temporär). Wichtig ist dabei, dass Google jedes Signal tatsächlich messen kann und darf. Denn die Google-Ergebnisse werden auf Dauer nur dann plausibel und damit gut sein, wenn sie auf einheitlichen Metriken basieren. Einzelfall-Metriken aus Google-Chrome (z.B. die echte Verweildauer) oder Google-Analytics (z.B. die Absprungrate) scheiden daher in meinen Augen aus.

Text-Analyse

Grundlage ist unstrittig eine Text-Analyse des Seiteninhalts. Hierbei greift Google nicht mehr auf „Keyword-Zählungen“ zurück. Diese simple Methode von anno dazumal führte natürlich seinerzeit zu massenhaft Keyword-Stuffing. Stattdessen analysiert ein inzwischen recht komplexer „Sub-Algorithmus“ einen Text hinsichtlich zwei wichtiger Faktoren:

- „Gehalt“ – wie viele echte Informationen stecken in einem Text

- „Schreibstil“ – wie verständlich bzw. plausibel ist der Text

Vor allem der Punkt „Gehalt“ wird im Rahmen der Diskussion um holistische Landingpages oft vernachlässigt. Denn natürlich kann man einen 5000 Wörter-Artikel mit schwafelnden Floskeln auffüllen, ohne dass er wirklich viele wesentliche Informationen in sich trägt. Oder man kann einen kurzen Artikel bis zum Platzen mit Fakten auffüllen. Beides ist für einen interessierten / suchenden Leser wahrscheinlich kaum geeignet.

Das Geheimnis liegt natürlich immer in der guten Mischung:

- so viele Informationen wie nötig (für die jeweiligen Suchanfrage),

- so wenig Text wie möglich (um schnell zum Gesuchten zu gelangen),

- so nachvollziehbar, plausibel und verständlich wie nötig (für die jeweilige Zielgruppe).

Alle drei Anforderungen lassen sich auf Basis von Entitäten und vergleichender Sprachanalyse realtiv gut messen. Entscheidend ist dabei (wahrscheinlich) die Datenbasis, die Google über Jahre gesammelt hat. Auf Basis von „künstlicher Intelligenz“ lassen sich so vergleichende Analysen anstellen.

Über Bilder und andere Medien kann man dabei eine „Uniqueness“ gewinnen, die den „Gehalt“ einer Website enorm steigern kann.

Holistische Landigpage (?)

Btw, zum Thema „Holistische Landigpage„: ich würde behaupten, dass der Punkt „so kurz wie möglich“ inzwischen sehr wichtig ist. Allerdings immer vor dem Hintergrund: „so viele Informationen wie nötig“. Das Wichtigste ist jedoch: wird die Information so rübergebracht, dass sie ein User gut lesen bzw. aufnehmen kann? (Auch in diesem Kontext spielen natürlich auch Bilder eine zentrale Rolle, weshalb sie in vielen Fällen einen positiven Einfluss auf das organische Ranking haben).

Aber zurück zu den Rankingfaktoren.

Nehmen wir mal (theoretisch) an, wir hätte eine solche „optimale Landigpage“ erstellt und hochgeladen. Sie wird von Google indexiert und … sie sortiert sich erst einmal auf Position 40 oder 50 ein (so meine Erfahrung aus vielen Beobachtungen).

Man wartet eine Woche, … oder zwei, … aber nichts passiert. Als Autor oder Seo denkt man nun: OK, war wohl doch nicht optimal, der Artikel. Weil vielen die Geduld fehlt, werden nun zwei Maßnahmen angedacht:

- Artikel „verbessern“, also weiter darin rumschreiben …

- Backlinks aufbauen, weil: ohne geht es ja nicht.

Beides ist in meinen Augen ein Trugschluss und führt nicht selten zu einer weiteren Verschlechterung. Denn: eine der wichtigsten Seo-Tugenden ist die Geduld.

Warten … Seo-Tugend Geduld

Google hat in seinem Algorithmus so eine Art „Bremse“ eingebaut. Auch der beste Artikel zu einem bestimmten Keyword wird es nicht von Anfang an auf Position 1 schaffen. Die Bremse hat in meinen Augen zwei Gründe:

- Mehrfache algorithmische Content-Analyse

- Abwarten, ob der Artikel auch (inhaltlich) so bestehen bleibt.

- Erfassen von (zunächst wenigen) statistischen Daten aus den Suchergebnissen.

Vor allem der letzte Punkt ist fundamental: jede neue Seite braucht einfach eine gewisse „Serp-Daten-Historie„, bevor sie es auf vordere Positionen schafft. Bei schwach umkämpften Keywords kann diese Zeitspanne kurz sein, aber je größer der Wettbewerb eines Keywords, um so wichtiger wird die „Daten-Historie“. Hier ist der Punkt „Return to the Serps“ – also „Rücksprung in die Suchergebnisse“ sicherlich von entscheidender Bedeutung.

Bei umkämpften Keywords kann es 8 bis 12 Wochen dauern, ehe ein inhaltlich guter und relevanter Artikel von Position 50 bis auf Position 10 vorrückt.

Soll heißen: eine zeitliche Komponente ist ein wichtiger Rankingfaktor. Je umkämpfter ein Bereich, um so größer die Verzögerung.

Erst nach Ablauf dieser Zeitspanne kann man als Seo (und auch der Google-Algo) wirklich beurteilen, wie gut der Inhalt eines Artikels für die Suchanfrage ist.

Backlinks (!)

Einer (!) dieser Faktoren zur Beurteilung von inhaltliche Relevanz und Qualität ist das Thema „Backlinks“. Aber da Backlinks der Sache nach ein natürliches und eindeutiges Signal sind – als Empfehlung einer Website für die eigenen Leser -, misst Google den Backlinks nach wie vor viel Bedeutung bei. Logisch, denn es gibt ja auch gar nicht viel mehr. Social-Media-Sharing basiert letztlich auch auf Links – wobei hier unklar ist, welche Links Google hierfür tatsächlich auswertet. In meinen Linkprofilen tauchte noch nie ein Facebook oder Twitter-Link auf. Dagegen allerdings schon z.B. Pinterest oder Google+ (R.I.P).

Die Anzahl und Qualität von Backlinks sind am Ende sicherlich wichtig, um über einige wenige Positionen zu entscheiden. Nicht mehr und nicht weniger, würde ich sagen.

Die Backlinks sind insofern ein besonderes Signal, als dass sie auf zwei Konten einzahlen:

- zum Einen auf einen einzelnen Artikel (Qualität einer Website),

- zum Anderen auf die gesamte Domain (Trust).

Trust (!)

Ein Faktor, der nur sehr langsam wächst und gedeiht, ist der Trust. Dabei geht es vor allem um Metriken, die das „Vertrauen der User in eine Website“ messen. Es ist also nicht die Frage, ob Google einer Domain vertraut, sondern ob es die User (potentiell) tun. Aus diesem Grund genießen Brands (also Marken) einen relativ hohen Stellenwert und werden in den Suchergebnisse häufig bevorzugt.

Der Trustwert ergeibt sich aus vielerlei Einzelsignalen (Rankingfaktoren), z.B.

- Alter einer Domain

- Erwähnung der Marke (Domain)

- Direkte Brandsuche (type-in in das Google Suchfeld)

- Backlinks

- Autor (Autoren), Redaktion, Impressum etc.

- Vernetzung der Marke, Domain, Autoren in Social-Media etc.

Nur Websites, deren Inhalt für eine Suchanfrage eindeutig relevant und geeignet ist und denen die User zudem noch vertrauen können, werden vorne angezeigt.

Je höher der Wettbewerb in einem Keyword(-Bereich), um so wichtiger wird der Trust-Wert. Etablierte Domains, häufig mit mit Brand-Bonus und vielen Backlinks, haben hier einfach Vorteile.

PageSpeed

Ein sehr wichtiger Faktor ist natürlich die Ladezeit. Denn nichts nervt Benutzer mehr, als lange (auf ein Ergebnis) warten zu müssen. Google hat die Messung der Ladezeit inzwischen deutlich verfeinert. Die Verbessung ist meist vor allem eine Quellcode-(Onpage-) Optimierung – aber natürlich auch eine Frage des Servers. Ich gehe hier mal davon aus, dass man eine schnelle Seite hat. Falls nicht, wird man es in den Serps nicht schaffen. Pagespeed ist ein „Muss-Faktor“ – im Zweifelsfall wird ein Wettbewerber mit ansonsten schlechteren Signalen bevorzugt.

Klickrate und Google A/B-Tests

Zuguterletzt sei noch die Klickrate erwähnt, also: wie oft wird ein Ergbenis in der Google-Suche tatsächlich angeklickt. Google fährt laufend A/B-Tests und wechselt die Positionen von 2-3 Ergebnissen für eine gewisse Zeit. Anfangs gerne nur Nachts, später dann auch mal für ein paar Tage werden neue Websites mal um ein paar Positionen nach vorne geschoben, um zu analysieren, wie denn die Klickrate und die Rücksprungrate ist.

Wie beschrieben, hat jede Domain so eine Art „Google-Daten-Historie„, und Google testet einfach, welche von zwei Domains die besseren Werte erzielt.

Auf diese Weise wird dann über mehrere Wochen oder Monate der „Serp-Feinschliff“ gemacht, ehe unsere oben neu erstellte Website dann nach ca. 12-16 Wochen tatsächlich auf Position 1 landet :-)

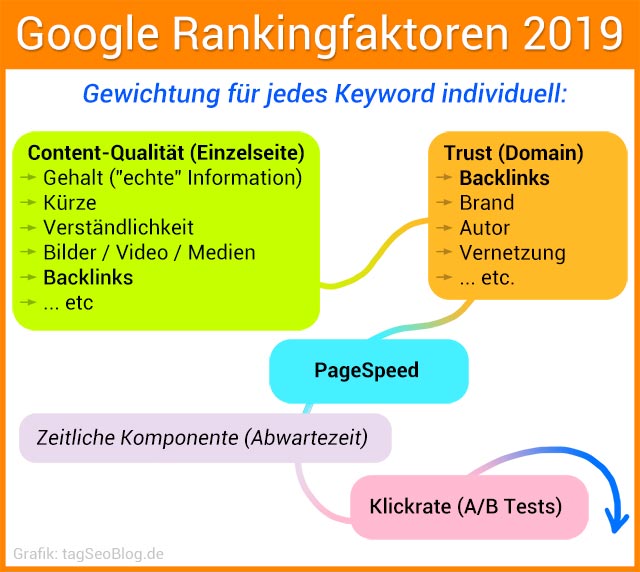

Zusammenfassung: Rankingfaktoren-Gruppen

Die laut Google 200 oder neuerdings 100 Rankingfaktoren lassen sich im Wesentlichen auf sehr wenige eindampfen:

- Content-Qualität (Einzelseite)

- Gehalt („echte“ Information)

- Kürze

- Verständlichkeit

- Bilder / Video / Medien

- Backlinks

- … etc

- PageSpeed

- Trust (Domain)

- Backlinks

- Brand

- Autor

- Vernetzung

- … etc.

- Zeitliche Komponente (Abwartezeit)

- Klickrate (A/B Tests)

Diese Hauptbereiche, die sich jeweils aus einer bestimmten Anzahl von Untersignalen ergeben, werden dann „algorithmisch“ gewichtet, was dann am Ende zu einer mathemtisch berechenbaren Reihenfolge führt (Ranking).

Wichtig ist, dass Google dank RankBrain mittlerweile für jedes Keyword individuell analysieren kann, welche Faktoren welche Gewichtung bekommen. So spielt z.B. im Medizin-Bereich der Trust-Faktor insgesamt, und im Besonderen die Brand und der Autor, eine größere Rolle als bei Fun-Bilder-Portalen.

Und vor allem die „Serp-Daten-Historie“ wird in meinen Augen oft unterschätzt. Jedes gute Ranking, jedes positive User-Signal, jede Erwähnung und jeder erfolgreiche A/B-Klickratentest zahl auf ein langfristiges Konto ein. Das wirkt zwar nur sehr, sehr langfristig – aber wenn es wirkt, dann ist es mächtig …

So, wie immer: alles nur meine Meinung, ich bin nicht Google, was meint ihr dazu? :-)

14 Gedanken zu „SEO Rankingfaktoren und Tugenden“

Die Performance einer Seite ist mittlerweile sehr wichtig geworden. Damit die Performance auch dauerhaft überwacht werden kann, haben wir die App Speedrank (speedrank.app) entwickelt. Damit bleibt jeder Seitenbetreiber stets über die aktuelle Performance der eigenen Webseiten informiert und muss nicht mühsam die Lighthouse Reports manuell erstellen.

Was meinst Du mit „Performance“? Ob JavaScript schnell ausgeführt wird? Ist ja ne Browser / User-Pc-Sache. Oder wie schnell der User liest und scrollt? Oder was?

Oder willst Du hier nur Dein Tool empfehlen? :-)

Hallo Martin,

okay, das war etwas unklar formuliert :)

Mit Performance meine ich die Seiten-Geschwindigkeit. Hier besonders was auch Google Lighthouse überprüft. Zum Beispiel: Wie lange wartet ein Besucher bis er eine Seite wirklich benutzen kann (Zeit bis Interaktivität). Dazu gibt es noch sehr viele weitere interessante Überprüfungen (Audits). Unser Tool soll das kontinuierlich messen und den Seitenbetreibern dafür eine Überwachung an die Hand geben. Ja, ich möchte auch unser Tool empfehlen ;)

Auf dieser Demo-Seite findest du ein Beispiel: https://speedrank.app/en/pages/3c5a74e7-25d9-4611-969b-8cd9d2a07cb1

Unabhängig von der Performance des PCs des Besuchers, kann man durch gewisse Strategien oder zum Beispiel den Einsatz von speziellen Add-ons im WordPress die „Frontend-Performance“ einer Seite steigern, vor allem profitieren hiervon dann auch Mobilgeräte.

Bei deiner Seite (tagseoblog.de) funktioniert unser Audit nicht richtig, da lege ich doch gleich mal eine Trello-Karte zum Bugfix an ;) (https://speedrank.app/en/lighthouse-audits/dab0a8d6-6edd-48e2-a002-1569629014c9).

Bei Backlinks steht (noch) „zahlen auf zwei Konto ein“

Ansonsten, sehr vernünftige Darstellung. Insbesondere das Warten können viele Menschen nicht, ich gehöre zu denen. Mein Sparring Partner im OLM sagt mir manchmal, wenn etwas wirklich nicht weiter geht im Ranking, auch etwas tolles: Arp, auf der ersten Seite können nun mal nur 10 Ergebnisse stehen, und für die 10 haben 10 ebenfalls hochklassige SEOs genauso 10x hart gearbeitet wie wir. Nur wegen uns zeigt Google nicht 11 an ;)

Ein guter und interessanter Artikel, danke. Ich bin allerdings skeptisch, was die Aussagen von Gary Illyes betrifft. Sie widersprechen dem, was langjährige SEOs ja bereits vielfach in der Praxis getestet haben, nämlich dass bestimmte User Signale durchaus Einfluss auf das Ranking haben. Ich sehe das ähnlich und Verweildauer und Absprungraten ebenfalls als relevante Faktoren. Zum anderen muss man bedenken, dass es nicht im Interesse von Google ist, Empfehlungen für SEOs zu geben oder mehr über den Algorithmus preiszugeben. Damit schadet Google sich selbst und öffnet die Türen für neue Black Hat Methoden für User Signale. Ich denke er spricht hier nicht ganz die Wahrheit :)

@Michael:

Ich glaube den Aussagen von Gary Illyes auch immer weniger. So langsam hab ich das Gefühl, die wollen so viel Unsicherheit wie möglich streuen und immer nur noch auf „Mach tolle Webseiten“ gehen. Besonders die Aussage, dass das Löschen von Seiten meist einen Rankingverlust mit sich bringt halte ich für eine sehr komische Behauptung.

Das widerspricht so ziemlich meiner Erfahrung und auch der Erfahrung vieler anderer SEOs mit denen ich mich regelmäßig austausche. Besonders das Löschen minderwertiger Seiten hat glaub noch niemandem geschadet.

P.S. @Martin: Es gibt auch seriöse Seiten mit 24 in der Domain ;) Lasse meine URL aber vorsichtshalber mal raus.

Schöner Artikel, ich würde mich mal freuen wenn Google die Seitenladezeit deutlich bevorzugen würde, was gefühlt bisher maximal ein kleiner Faktor ist.

Mit der Text Kürze kann ich mich gerade nicht so anfreunden, da wir wirklich bei quasi allen Seiten mit größeren informativeren Texten (aber auch Dopplungen Sinn mäßig drin) immer bessere Rankings erzielt haben.

Was glaubst du, was es mit der Klickrate aufsich hat, wird man jetzt eher die Metatags optimieren müssen um dadurch mehr Klicks zu bekommen (natürlich wird auch die Aufenthaltszeit gemessen)?

Kann ich zum Teil nur zustimmen. Vor allem ist Google zwar zu vielem in der Lage, aber mal ehrlich… gute Ratgeber stehen oft auf Seite sonstwas, während schrottige Firmenseiten ganz oben sind. Das beobachte ich auch derzeit beim Medic Update wieder. Sinnvolle Nischenseiten, die ein Thema wirklich gut erklären und erweitern, rutschen teilweise nach unten, während simple Firmenwebsites mit wenig Text oder gar Online-Shops nach oben gelangen.

Könnte man jetzt mit User-Intention rechtfertigen, aber sehe in vielen Fällen den Sinn dort noch nicht. Zumal es auch einige Shops betrifft, die wirklich gute Ratgeber zu ihren Produkten geliefert haben, damit aber plötzlich verschwunden sind. Im Austausch mit 300 Wörtern Artikeln.

tl;dr: Wäre Google so clever, würde so ein Mist nicht oben landen. Ganz einfach.

PS: Ich nutze jetzt seit einem Jahr DuckDuckGo als meine Hauptsuchmaschine. Die macht vieles anders und was zu Beginn noch merkwürdig wirkte, bringt mir jetzt einfach dauerhaft sinnigere Ergebnisse. Klar, DuckDuckGo ist ein Hybrid und nicht komplett Eigenentwicklung… es funktioniert (nach Umgewöhnung) aber dennoch viel besser als Google.

Kann jedem nur empfehlen das mal auszuprobieren. Also nicht mal eben so, sondern wirklich mit Überwindung der Umgewöhungsphase. Tolle Erfahrung, die auch zeigt wie sinnlos bei Google vieles sortiert scheint.

Es ist halt wie mit allen Systemen: Sie werden manipuliert. Google hat ein Ranking, welches nach bestimmten Regeln vorgeht, aufgebaut. Lass es Backlinks, semantische Netze, Ladezeiten, etc sein. Es gibt ein Regelwerk (welches ein Geheimnis ist, aber durch Versuche teilweise entschlüsselt werden kann) und dieses wird genutzt, um Seiten aktiv nach oben zu bringen. Irgendwann ändern sich die Regeln. Und das Spiel beginnt von vorne.

Aber ich muss google in sofern zugestehen, dass, obwohl die Ergebnisse immer noch nicht perfekt sind, es doch deutlich besser geworden sind. Wir können uns bestimmt alle noch an die Zeit erinnern, wo reines Keywords Spamming auf einer Seite gereicht hat, sich nach vorne zu katapultieren.

Hallo Martin.

„Was Google könnte und was Google macht…. ;-)) stimmt.

Frischer Content? Unbedingt! Das Ganze mit Bildern bestickt und Bildunterschriften ausstatten. Und natürlich mit Headlines und Sublines den Texte auflockern. Problematisch sehe ich aber die Abwägung von kurzen knackigen Texten auf der einen Seite und ausführlichen Erläuterungen auf der anderen Seite.

Und nicht zu verachten ist die interne Verlinkung!!!

Warten ist sicherlich ein wichtiger und nicht zu unterschätzender Aspekt. Allerdings dürfte das Thema Backlinks vor allem in sehr hart umkämpften Nischen wie zb. dem Finanzbereich etc. noch immer eine gewaltige Rolle spielen. Ich habe mir einmal den alten Artikel zu der Brillenunterseite ohne Backlinks durchgelesen. Hier ist es ja erst nach rund 12 Wochen passiert – also eine stolze Zeit. Interessant wäre dein Experiment, wenn du eine völlig neue Domain und dazu quasi nen Onepager nur zu diesem Thema gemacht hättest. Ich glaube das ist fast unmöglich dann zu ranken. Oder wie meinst du das? Eine neue Domain ohne Trust und ohne Links kann auch in den Top 10 ranken?

Auch für das Ranking der Webseite spielt Pinterest eine wichtige Rolle. Die Postings auf Pinterest (Pins) mit Webseitenlinks werden als Social-Media-Signal von Google gewertet.

Ich denke du hast in deinem Beitrag die wichtigsten Rankingfaktoren aufgelistet. Ich wundere mich immer wieder, wenn es Seiten gibt, die Backlinks abschreiben und ausschließlich auf Content setzten. Ich bin auch der Meinung, dass Content der wichtigste Punkt ist, jedoch sollte man die Technik(Pagespeed) und Offpage Faktoren nicht vernachlässigen.

Ein sehr interessanter Artikel. Ich beschäftige mich seit ein paar Wochen mit SEO und konnte einige neue Dinge lernen. Jetzt weiß ich, womit ich mich nochmal in der nächsten Zeit beschäftigen kann und was ich noch lernen muss. Vielen Dank dafür!

Kommentare sind geschlossen.