Phantom-Update: DC kein positiver Rankingfaktor mehr (?)

Das letzte Google-Update gibt viele Rätsel auf. Da ich selber betroffen bin, habe ich viel analysiert und kombiniert. Es zeichnet sich so langsam ein Bild ab, und ich möchte mal den Versuch einer Erklärung wagen, was da passiert ist sein könnte. Google hat inzwischen bestätigt, dass es sich um ein „Core-Update“ handelt, also eine grundlegende Änderung am Herzstück des Algorithmus – mehr will man darüber aber nicht sagen. Einige interessante Beobachtungen kann man bei „Frag-Sistrix“ nachlesen.

Duplicate Content

Für das Verständnis meiner Erklärung ist zunächst das Thema Duplicate-Content (DC) wichtig. In grauer Vorzeit hieß es mal „Duplicate-Content ist böse„. Das ist dann der Einsicht gewichen, das DC eigentlich egal ist – nur dass Google eben nur eine Seite davon in den Ergebnissen listet. Wenn also Seite A einen originären Artikel schreibt, und Seite B den 1zu1 kopiert, dann war das bislang egal, solange Seite A dafür gerankt hat. Erst wenn Seite B die Seite A aus den Rankings verdrängt hätte, würde der Autor von A sauer werden und das ganze als Problem darstellen. Für Google hat das Ganze keine Rolle gespielt, weil das Ergebnis ja letztlich identisch war.

Nun ist DC aber nicht immer nur die 1zu1 Kopie, sondern kann auch nur in Teilen identisch sein. Wo genau die Grenze zwischen Unique und Kopie liegt, ist umstritten, aber hier jetzt erstmal unerheblich.

Der Seitentitel

Auch wenn es alle wissen, hier noch mal zum mitschreiben: der Seitentitel ist nach wie vor ein sehr wichtiges Signal für den Inhalt einer Seite.

Duplicate Content & veränderter Seitentitel

Seit einiger Zeit war es möglich, mit internem Duplicate Content für verschiedene Keywords gut zu ranken. In der Tat habe ich das auch getan, und ich habe nichts Verwerfliches daran gefunden. Ich habe es sogar empfohlen. Denn oberstes Ziel sollte sein, dem Benutzer ein gutes Ergebnis zu bieten.

Ein Beispiel …

Ich möchte das an einem Beispiel veranschaulichen: Nehmen wir an, ich habe eine Seite über Lesebrillen. Die rankt gut für das Keyword (siehe Glossar) „Lesebrillen“, sagen wir mal auf Pos. 8. Soweit sogut…

Nun suchen aber viele User nicht (mehr) nach dem „Shortkey“, sondern zum Beispiel nach „Lesebrillen 1 Dioptrie“. Zu diesem Keyword rankt meine Seite nur auf Platz 20 (oder so). Wer sich mit der Materie auskennt, weiß, dass die Dioptriezahl nur beim Bestellen relevant ist. Alle übrigen (Ratgeber-) Informationen über Lesebrillen sind identisch, egal oder +1, +2 oder +3 Dioptrie.

Nun habe ich also drei Unterseiten erstellt, die jeweils mehr oder weniger Kopien des ersten Artikels waren, und nur der Seitentitel ist jeweils verändert („Lesebrillen +1 Dioptrie“ etc.) Im ersten Absatz befindet sich jeweils eine kurze individualisierte (unique) Beschreibung, ansonsten sind die Artikel identisch.

Was hat das zur Folge gehabt?

Nur gutes (bis vor kurzem ;-). Denn es rankten nicht nur die Unterartikel zu ihren Longtail-Keywords auf vorderen Plätzen, sondern vor allem beim „Shortkey“ konnte meine Ursprungsseite locker ein paar Plätze nach vorne wandern. Es war also – Seo-technisch gesehen – eine absolute Win-Win-Situation. Im Zweifelsfall haben sich Seiten kannibalisiert, teilweise waren sogar mehrere Seiten gleichzeitig auf vorderen Plätzen – wenn Google offenbar die User entscheiden lassen wollte, welche Seite besser ist.

Habe kein schlechtes Gewissen

Nun werden einige sagen: der Mißfeldt ist ja ein alter Spammer. Finde ich nicht, denn ich habe viel positives Feedback auf solche „Unterseiten“ erhalten. Und ich habe das damals auch nicht gemacht, weil ich Google damit auszutricksen wollte, sondern weil es für die Benutzer sinnvoll zu sein schien. Die Logik dahinter ist, dass man alle relevante Information auf einer Seite bereithält (die berühmten „Onepager“). Bestimmte Informationen sind eben auf vielen Unterseiten relevant – sie doppeln sich folglich. Man erspart dem User damit das weiterklicken – positiv formuliert.

Alles hat ein Ende …

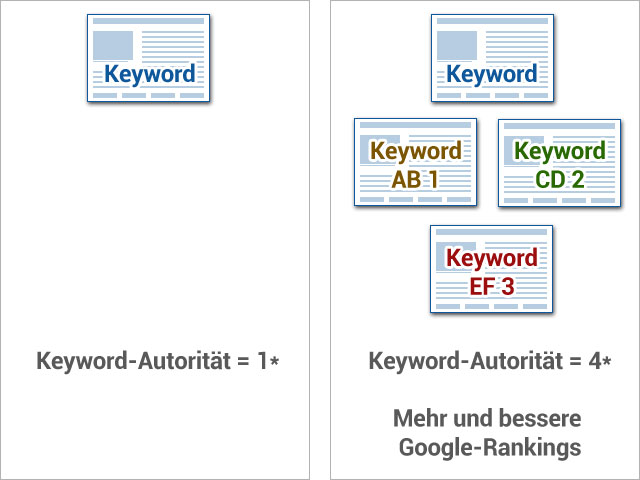

Genau diese „Methode“ scheint nun abgestraft worden zu sein. Oder besser gesagt: sie zieht nicht mehr. Bislang hatte es offensichtlich die Autorität einer Seite gestärkt, wenn bestimmte Begriffe auf vielen Unterseiten vorhanden waren.

Nach meiner These ändert das Phantom-Update nun die Art, wie Google den Faktor Autorität berechnet: Begriffe, die sich sitewide durch internen duplicate Content hochsummiert haben, sind nun abgerutscht. Die Kopien zählen nicht mehr mit, die Seite verliert an Autorität zu einem Begriff – und rutscht in der Folge vor allem bei den Shorttail-Keywords ab.

Daher meine Formulierung:

Autorität (als siteswide-Faktor) ist zurückgestuft worden, weil Duplicate Content nun nicht mehr mitgezählt wird.

Was tun?

Ich bin noch weit davon entfernt, anderen Ratschläge geben zu können. Aber ich habe auf meiner Brillenseite angefangen, zwei Methoden auszutesten:

- Seiten mit mehr als 80% Duplicate-Content werden gelöscht.

- Seiten mit 40 – 80% DC lasse ich bestehen, erstelle aber aus dem DC eine unique Unterseite, die überall verlinkt wird, wo es vorher als DC stand.

- Seiten mit weniger als 40% DC schreibe ich um, so dass es jeweils noch konkreter um das jeweiligen Seitenthema geht.

[die Werte sind so ungefähr] Ich mache jede Methode für jeweils ein bestimmte „Keyword-Set“, so dass ich in einigen Wochen besser analysieren kann, ob und was das gebracht hat.

Aber, klar ist: ich hatte mir offensichtlich mit den DC-Trick einen Vorteil verschafft (was mir so gar nicht klar war), den ich jetzt verloren habe.

Ein Zurück zum Zustand wie vor ein paar Wochen wird es nach miener Überzeugung nicht geben.

Was meint ihr? Plausibel? Könnte es Eure Verluste erklären?

70 Gedanken zu „Phantom-Update: DC kein positiver Rankingfaktor mehr (?)“

Hi Martin,

die Schlussfolgerung finde ich komisch „Autorität (als siteswide-Faktor) ist zurückgestuft worden, weil Duplicate Content nun nicht mehr mitgezählt wird.“ Die Autoriät einer Domain wird nach meiner Meinung in erster Linie durch Reputationssignale, Alter der Domain etc. und dadurch bestimmt, wie ganzheitlich ich bestimmte Themen behandle. Warum sollte DC bisher als Autoritätssaignal gewertet worden sei? Macht für mich keinen Sinn…

Ok, dafür müssten wir eine Grundsatz-Diskussion zum Thema Autorität führen, weil ich das offenbar anders einschätze ;-)

Es spielt aber letztlich keine Rolle, ob man es „Verlust von Autorität“ oder anders nennt. Mir geht es im Artikel um das (mögliche) „nicht mehr Werten von DC“.

„Autorität ist im weitesten Sinne eine soziale Positionierung, die einer Institution oder Person zugeschrieben wird und dazu führt, dass sich andere Menschen in ihrem Denken und Handeln nach ihr richten.“:-)

Das mag für Menschen stimmen, aber nicht für den gleichnamigen Rankingfaktor von Google (denke ich) :-)

In diesem Fall sind wir dann unterschiedlicher Meinung. In den quality rater guidelines z.b. wird ansatzweise beschrieben wie authority und Expertise durch die sich evaluatoren zu deuten ist.

Also das mit dem DC finde ich dann aber auch gerechtfertigt. Schließlich hast du ja wie selbst beschrieben diese Seiten auf das Ranking in Suchmaschinen ausgerichtet und nicht primär auf den Nutzer.

Dann hast Du mich oben falsch interpretiert (oder ich mich unklar ausgedrückt): ich glaube nach wie vor daran, dass es für die User besser ist, eine umfangreiche Ratgeberseite zu bekommen als ein „Durchklick-Stückwerk“. Und umfangreiche Seiten (zu Longtail-Anfragen) ziehen nun mal zum Teil identische Informationen nach sich.

Ich glaube nicht an das DC-Thema. Es gibt nach wie vor viele Seiten, die annähernd zu 100 % aus tausenden DC-Seiten bestehen, welche sich nur durch modifizierte Title-Tags und den Austausch bspw. eines Ortsnamens im Content unterscheiden und super ranken, teilweise besser als vor dem Phantomupdate. Ich bin gespannt.

Dafür hätte ich gerne mal ein oder zwei Beispiel – weil es meine These prima widerlegen könnte. Hast Du welche parat?

nicht öffebtlich. Ich sende Dir eine PN.

Hallo Martin,

ich widerspreche Dir auch, dass es an DC liegt, da meine DC-Seiten keine Sichtbarkeit verloren haben, wichtige Kategorieseiten mit uniquen Content hingegen schon.

Beispiele für DC-Seiten:

http://www.goldsilbershop.de/gold-kaufen-verkaufen-wiesbaden.html

http://www.goldsilbershop.de/gold-kaufen-verkaufen-mainz.html

http://www.goldsilbershop.de/gold-kaufen-verkaufen-mannheim.html

http://www.goldsilbershop.de/gold-kaufen-verkaufen-dresden.html

http://www.goldsilbershop.de/gold-kaufen-verkaufen-hamburg.html

Abgestraft wurde hingegen

http://www.goldsilbershop.de/goldbarren.html

Ich habe einmal untersucht wie häufig werden die Brands innerhalb meiner Branche gesucht. Bis auf einen Ausreißer war erkennbar, dass Seiten deren Brand häufiger gesucht wird, gewonnen haben und wir, die leider weniger Brandsuchen haben, mit -44% deutlich verloren haben.

Freue mich auf weitere Diskussion zum Thema aus dem ich Lehren ziehen kann!

Tim

Hi Martin,

genau so ist es und darüber wundere ich mich seit zwei Tagen!!! Meine WP Seite hat ein Portfolio und ein Shop mit dem selben Title. Vorgestern war ich auf Platz 1 bei Google und heute ist meine Website nicht mehr im Ranking zu finden!

Nur das Bild ist unter Google Bilder noch auf 1.

Da ich erst ein Produkt mit dem selben Title und Content angelegt habe, kann ich entsprechend weiter machen ;-)

Danke super Info!!!

Wenn die Seite vorgestern noch auf Platz 1 war, dann hat es (vermutlich) nichts mit dem Phantom-Update zu tun, das ja schon vor ca. 10 Tagen ausgerollt wurde.

Nach meiner Einschätzung ist es auch durch – ich sehe keine großen Veränderungen mehr, wenn dann nur minimale „Korrekturen“ – vermutlich, weil sich bei einigen keywords andere (User-Signale) durchsetzen und die zurückgesetzten Seiten wieder nach vorne bringen. Aber das beobachte ich eher vereinzelt.

Die Duplicate Content Idee könnte ich eventuell mitgehen :-). Aber dazu schreib ich Dir mal privat.

hehe, ja ich hatte auch gezögert, ob ich das öffentlich schreiben soll. Ist irgendwie wie nackt ausziehen in der Fussgängerzone ;-)

Aber was soll’s: wir wollen ja vorankommen…

Danke, dass Du Dich für uns „nackig“ gemacht hast :D

Hi Martin,

Deine Methode entspricht genau dem, was Google nun als Brückenseite oder Doorway Page bezeichnet:

„Doorways are sites or pages created to rank highly for specific search queries. They are bad for users because they can lead to multiple similar pages in user search results“

Mit der Neudefinition des Begriffs Mitte März hatte Google auch die Folgen angekündigt:

“Um die Qualität der Suchergebnisse für unsere Nutzer zu verbessern, werden wir in Kürze eine Rankinganpassung im Hinblick auf Seiten dieser Art vornehmen.“

Das Phantom-Update könnte daher vielleicht einen ordentlichen Namen erhalten: Doorway Day :-)

http://lautzeichen.de/doorway-day-googles-angriff-aufs-content-marketing/?

Hi Ralf,

wobei Google ja das Doorway-Update wie du schreibst konkret angekündigt hat und für das Phantom Update konkret sagt dass sie nichts darüber erzählen wollen.

Es kann natürlich sein dass Martin vom Doorway-Update getroffen wurde und es gar nichts mit dem Phantom Update zu tun hat. Die zeitliche Nähe würde es schwierig machen die 2 Updates voneinander zu trennen.

Gruß

Valentin

Ich habe nie wie der Mißfeldt gespammt, bin trotzdem nach unten durchgereicht worden.

jaja, jetzt habe ich meinen Ruf weg … :D

Aber danke für den Hinweis, haben ja schon mehrere geschrieben, dass sie offenbar aus anderen Gründen an Boden verloren haben. Der Artikel ist insofern ein Baustein bzw. Denkanstoß.

Hallo Martin,

sehr interessanter Ansatz, für mich aber leider bei Projekten in meinem Zugriff so nicht nachzuvollziehen. Sogar ganz im Gegenteil. Seiten mit dünnem Inhalt und Near Duplicate Inhalt (sogar über Domains hinweg) sind als Netzwerk wieder aufgetaucht.

Dagegen sehe ich bei Kunden mit guten Seiten starke Verlust.

Für mich ist allerdings fast immer bei den Verlusten ein Gewinner mit Brandvorteil zu erkennen. Insofern spielt auf jeden Fall Brand ein Rolle.

Ja das stimmt. Etablierte Brands haben deutlich zugelegt, wohl mehr als die Verluste einiger Seiten erklären können.

Meine Seiten sind sicher kein Brands

Wie sind denn bei Dir die Brands (Shops mit Marken und die Marken selber) gewachsen?

Vielleicht macht es Sinn mal zu schauen wo Seiten deutlich gewonnen haben!? Ich betreue mehrere kleine Reise Seiten die alle bis zu 400% über den gesamten Zeitraum der letzten 14 Tage gewonnen haben. Alle sind gleich aufgebaut. Alle haben gute User Signals bis hin zur Conversion. Alle Seiten haben hohe Adwords Budgets. Alle Seiten widmen sich jeweils nur einer Reise und damit einem gezielten Thema. Und zu allen Seiten wurde niemals Links aufgebaut. Ich kann mir vorstellen, dass User Signals gegenüber Links stärker gewichtet werden. Ältere, schlechtere Konkurrenz Seiten hatten sicherlich bessere Links, … aber schlechtere UX

Hallo Martin, an Deiner These könnte schon was dran sein. Ich selbst habe mich mit dem Update nicht wirklich auseinander gesetzt. Bei meinen Seiten konnte ich im Ranking weder große Verluste noch große Gewinne verzeichnen und die von Dir beschriebene DC Methode wende ich nicht an. Insofern könnte das passen.

Ein Kumpel hatte mir erzählt, dass google verstärkt die Ladezeiten der Seite bewerten wollte. Darunter zählte dann auch, ob eine Seite für mobile Geräte optimiert wurde. Hast du deine Seiten darauf schon einmal untersucht?

Interessanter Ansatz. Jedoch auch bei mir nicht nachvollziehbar. Ich habe mittlerweile bis zu 20 Shops & Unternehmensseiten verglichen. Saubere simple Seiten. Fazit: Gewinner und Verlierer. Ich sehe es gar nicht direkt in den tatsächlichen Rankings begründet.

Das Update für mobile Geräte war. Zugriffe über mobile Geräte sind bei einigen Kunden trotz mobiler Varianten um bis zu 60% gesunken. Desktop gleichbleibend. Es gibt neue Rankings im mobilen Segment. Werden Verlierer dort nur nicht einfach schlechter gelistet und büßen durch diese Positionen an Sichtbarkeit ein?

Es ist doch schon lange Zeit bekannt, dass Google sämtliche Aktivitäten/Formen bezüglich DC abstraft bzw. abstrafen wird?!

Interessant finde ich es jetzt auch, dass meine SEO-Kunden keinerlei einbußen zu verzeichnen hatten, im Gegenteil: Verbesserungen!

Vielleicht habe ich auch etwas missverstanden;)

LG

Wir haben es auch dahingegend optimiert das wir mit mehreren Keywords aber dem gleichen Produkt in Google gelistet waren. Also zum Teil dann auch mehrfach. Wir hatten dennoch einen ordentlichen Boost nach vorne. Ein Partner der mit der gleichen Seite / Aufbau arbeitet dennoch eine ordentliche Abwertung. Dieser optimierte nicht in diese Richtung.

Ich denke eher das es am duplicate content liegt. Diesen haben wir immer schon versucht zu reduzieren und zu unterbinden.

Unser Online Shop stellt gerade neue Traffic Recorder auf was uns sehr freut. Aber eventuell reguliert sich dies in den nächsten Tagen wieder.

Mal sehen was die nächsten Wochen bringen.

SG Manuel

Meiner Meinung hat Goo diesen Monat den angekündigten Realtime-Panda Algo gestartet. Ich habe in den letzten Monaten verstärkt schwachen Content auf noindex gesetzt, musste danach zwar mit Einbrüchen leben aber in den letzten Wochen bekomme ich mehr und mehr Auftrieb. Des Weiteren erholt sich ein von Panda abgestraftes Projekt stetig – ich gehe davon aus dass das ganze auf ein Panda-Refresh-Update hinzielt!

Journalistisch gesprochen: „Wir wollen ja nicht spekulieren, aber…“ ;-)

…nope, kann ich so auch nicht bestätigen.

Trotzdem bin ich wieder froh über Deine Eindrücke die daraus resultierenden Kommentare.

Gruß

Miladin

Es macht mit so tollen Lesern einfach Spaß zu bloggen. Da verliert man doch gerne Rankings :-)

Vielen Dank für die zahlreichen Beispiele, die ich inzwischen per Mail oder PM erhalten habe. Witzig, dass kaum jemand darüber in den Kommentaren schreiben mag :-)

Anyway, was ich dabei festgestellt habe:

Es gibt in der Tat noch einige Seiten, die die oben beschriebene Methode (DC auf lokalisierten Unterseiten) extensiv betreiben – und damit (trotzdem) zu den Gewinnern des Updates gehören. Insofern ist die oben genannte These offensichtlich vermutlich falsch. Aber: interessant ist dabei, dass es sich bei allen Projekten um sehr kleine handelt, die jeweils maximal eine Sichtbarkeit von 0,1 oder weniger haben. Man kann jetzt natürlich sinnieren, inwiefern das an dem Sichtbarkeitsindex bzw. dem begrenzten Keyword-Set liegt. Ich halte die Beispiele daher nur bedingt für aussagekräftig.

Ich glaube, Google steuert gerade gegen.

Meine Seite ist ebenfalls nach Deinen Maßstäben klein. SI von 0,13 auf 0,06 abgesackt.

Besucher (gesamt) pro Tag 1500 – 2000.

Besuchereinbruch über die organische Suche von 900 Besuchern am Dienstag auf Mittwoch 500 Besucher. Gestern wieder über 900 Besucher über die organische Suche.

Bin einmal gespannt wie der SI nächsten Sonntag aussieht.

SEO ist zwar interessant, aber nichts auf das man sich verlassen sollte. ;-)

Hi Martin,

meines Erachtens geht es stark in die von dir beschriebene Richtung + Branding.

Sichtbarkeit 0,1 würde darauf schließen lassen, dass es sich bei den jeweiligen Seiten nicht um „Autoritäten“ / Brands handelt.

Near Duplicate Content hat bei von uns betreuten Projekten auf jeden Fall an Sichtbarkeit verloren. Diese Projekte sind auch keine Brands insofern könnte das hinkommen.

Grüße

Hendrik

Hi Martin,

würde bei deiner These mitgehen. Habe bei einem Kunden zwar nicht 1:1 DC aber seine Navigationsstruktur ist sehr unsauber, sodass einige exakt gleiche Themen über 4 verschiedene Navigationspfade (immer mit separater URL) zu erreichen sind. Somit haben auch mehrere URLs zu einer Keywordwolke gerankt. Bin gespannt wie es da weitergeht. Viele Grüße!

Hi

ich betreibe nen Online shop und versuche unique Texte zu verfassen. Ich denke das bei den Kategorietexten bei mir kein DC besteht. Da die Artikel aber automatisiert hochgeladen werden und die Hersteller Beschreibung, die auch andere Shops nutzen,könnte

das vielleicht die ursache sein?!? Für meinen Rankingverlust?

Hi Martin,

in einem anderen Bericht des Phantom-Updates von Glenn Gabe http://www.hmtweb.com/marketing-blog/phantom2-google-update-april-may-2015/

steht folgender Kommentar:

„You should be aware of another strange phenomenon, which seems to be related to this quality update!

Since the last week of April, the CPC for many Adsense publishers has plummeted to a level unseen until now. We are talking about -40-60% for medium CPC, with was relatively stable for years.

The Webmasterworld Adsense forum (May thread) is screaming in terror .

Check with your affected and non-affected sites to see the trend of earnings.

I suspect we see the first quality update for adsense publishers!“

Du hast ja auf all deinen betroffenen Projekten adsense. Hab auch einige andere Verlierer gesehen die viel adsense drauf haben.

Seiten die aus den Bereichen Hersteller oder Handel kommen und damit keine adsense einbinden haben was ich so gesehen hab eher gewonnen oder zumindest nicht verloren. Meine kleine Auswertung ist zwar bei weitem nicht repräsentativ trotzdem würde mich dazu deine bzw. eure Meinung interessieren. Veränderung bei adsense publishern ja oder nein?

Ich bisher

Hey Stefan,

Ich habe Kunden in einer Nische,in der nicht mit Adsense gearbeitet wird, aber habe zumindest bei einem unstimmigkeiten bei der Benutzung vom Canonical Tag gefunden. Der ist sehr deutlich abgeschmiert, was die DC These untermauern könnte.

Was die Brand angeht, ist genau dieser Verlierer eigentlich eine der Topbrands in dieser Nische :/

Hallo Stefan,

diese mögliche Verbindung konnte ich ebenso identifizieren. RPM -40%, SI -15%, sukzessiver Rückgang seit Ende April.

dickes lob an den nackten differentialdiagnostiger.

ich habe mehrere projekte wo deine analyse im positiven wie auch im negativen eine sehr gut passende erklärung bietet.

auch die verbindung doorway mit DC, die ralf angesprochen hat finde ich gut.

man muss auch bedenken, dass man von google in sachen dc schon lange nichts mehr gehört hat. und da das thema relativ wichtig ist und da google ziemlich viel personal hat, so ist es dann auch wahrscheinlich, dass sich bei google damit immer ein paar leute beschäftigen und dann auch mal irgend was dazu kommt.

extrem beklemmend finde ich, dass google sämtliche standards diktiert und man denen ob man will oder nicht machtlos ausgeliefert ist. youtube als größte DC spam schleuder ist dann interessanterweise nicht davon betroffen.

zu den brands und zu ecommerce. google veröffentlicht gern mehrere updates fast gleichzeitig um nicht so leicht lesbar zu sein. ich glaube, dass dies zwei weitere unabhängige updates sind, die zeitnah live gegangen sind.

Mit ist bei einen Projekt aufgefallen aus dem Gesundheitsbereich wo Beratungscontent auf einer Subdomain liegt, das die Beratungsseiten schwer an ranking verloren und die Produktseiten schwer gewonnen haben.

In der Tat, dass mit den 2 zeitgleichen Updates hört sich logisch an. Ein „Adsense“-Update *und* ein DC-Update!? Das würde bei mir *alles* erklären: Den Trafficverlust von 50% aufgrund relativ starken DC (Martin, Du bist der Euphemist des Monats, nein: des Jahres! „Duplicate Content als positiver Ranking-Faktor“! Yeah! Ich würde Dich sofort als Verkäufer einstellen *gg*) und ein neuer „CPC-Rekord“ von 0,05 Euro – so wenig hatte ich noch nie. Meine Konsequenz daraus ist daß ich versuche unabhängiger zu werden: Ich plane a) Produkte unter eigener Marke zu verkaufen und b) für alle Sites irgendeine Art von nützlichem E-Mail-Newsletter aufzubauen. Denn Kontakte kann mir Goo nicht wegnehmen. Damit mache ich dann meinen eigenen Traffic, hah! ;-)

DC kann es bei mir nicht sein (und ich hab massiv an Sichtbarkeit verloren), denn ich produziere einzigartige Textinhalte, die weder auf anderen Domains noch innerhalb meiner Seite mehrfach vorkommen. Mein OVI ist von 6 auf 3 gesunken.

Hallo Martin,

ich glaube nicht, dass es etwas mit DC zu tun hat. Ich betreibe u.a. mehrere Webseiten die sehr stark auf internem DC basieren (5stellige Seitenzahlen, kaum unique content, >80% DC) und diese haben größtenteils stark zugelegt (20-30% +)! Lediglich eine einzige meiner Webseiten ist um knapp 20% abgerutscht und gerade die besteht zu 100% aus unique content! Bislang finde ich noch absolut keine Erklärung dafür, aber DC kann ich bei meinen Projekten als Negativ-Faktor ausschließen.

Paul

DC kann ich für mich ebenfalls ausschlissen. Es sind bei mir hauptsächlich Onepager mit vergleichsweise viel Content betroffen.

Hallo Martin,

danke für diesen informativen Beitrag.

Für mich ist das auf den ersten (und auch zweiten) Blick ziemlich schlüssig. Unsere Website ist seit einigen Wochen im (leichten) Aufwärtstrend, seit ich mich intensiv mit SEO beschäftige. Unsere Mitbewerber (einer davon rankt noch sehr viel stärker) habe ich hinsichtlich ihrer SEO-Aktivitäten untersucht. Dabei kam heraus, dass diese von der Usability her viel schlechter sind aber u.a. sehr viel DC (meist Textbausteine) besitzen. Und diese Seiten sind in den letzten 14 Tagen doch etwas eingebrochen.

Es wird spannend sein, dass weiter zu beobachten.

Viele Grüße

Rolf

Hallo,

gegenüber Search Engine Land hat Google die Veränderungen am “core algorithm” bestätigt. Man könnte es “Quality Update” nennen, schreibt Barry Schwartz bei http://searchengineland.com/the-quality-update-google-confirms-changing-how-quality-is-assessed-resulting-in-rankings-shake-up-221118

Das Phantom hat jetzt also einen Namen bekommen. ;-)

Jochen

Interessanter Beitrag, ich bin auch betroffen, allerdings positiv! 2 von 3 Seiten haben plötzlich deutlich mehr Traffic von Google.

Solche Sachen wie du habe ich aber auch nicht gemacht. Ein schlechtes Gewissen musst du aber wirklich nicht haben, ich finde auch, dass es so einen Mehrwert bietet und wüsste gar nicht, wie man es anders machen soll. Es ist nun mal so, dass der Content gleich ist bei +1 oder bei +2 Dioptrien… Und sinnlos die ganzen Keywords in einen Artikel zu platzieren kann schließlich auch nicht die Lösung sein.

Schöne Grüße,

Marc

Ich denke, wir sind mit den Vermutungen bezgl. DC, Brand und UX alle auf dem Holzweg. Aus rein technischer Sicht sind dies „nur“ Faktoren, die in den Hauptalgorithmus einfließen. Modular gedacht wären dies drei verschiedene Bausteine, an denen justiert werden müssen. Da aber seitens Google offiziell die Rede von einer Anpassung am Core ist, würde ich alle drei Ansätze erst einmal außer Acht lassen und mir Gedanken darüber machen, was Anlass dazu geben könnte, grundlegende Justierungen vorzunehmen.

Hier würde mir spontan nur die Indexierung von Inhalten aus Twitter einfallen. Davon war ja schon vor einiger Zeit die Rede, dass dies kommen wird. In den mobilen Sucheergebnissen sind die Tweets schon drin (http://googleblog.blogspot.de/2015/05/tweets-take-flight-in-google-app.html). Bei dieser Masse an neuen Ergebnissen bedarf es definitiv ein Update. Und dies sorgt auch für Bewegung im Ranking. Könnte was dran sein, oder?

Könnte in meinem Fall absolut hinkommen, ich bin in meiner Branche überhaupt nicht auf Twitter vertreten (ist irgendwie auch kein wirklich schnelllebiges Thema, daher sah ich das nie als notwendig). Die großen Brands („Fach“-magazine mit großen Social-Media Budgets), die jetzt besser ranken sind sicherlich auf Twitter gut vertreten.

Diese Theorie müsste man ja sehr leicht anhand von Sistrix-Daten belegen oder widerlegen können.

Ichhabe für meine Niesche auch analysiert – Spezialbereich im Oberthema Reisen. Ich glaube, dass guter Content abgestraft wird. Ist ja kein Wunder, nach Penguin und Panda wird mit weniger Linkspam gearbeitet und mehr qualitativem Content. Da das jetzt sehr viele so handhaben, muss qualitativer Content abgestraft werden.

Losgelöst von meinem Thema musste ich nach Autoteilen suchen und auf den vorderste Rängen war bei mehreren Suchen eine Seite, wo jede der abertausenden Beschreibungen gleich ist nur der Name vom Ersatzteil sich ändert. Was dann zu Artikelbeschreibungen führt wie „Genießen Sie den hohen Fahrspaß Ihres : Ein ist nur so gut, wie

sein schwächstes Teil. Original Steuergerät Klima komplett mit Bedienteil stimmen in Qualität“.

DAS rankt nun richtig gut. Ich bin am Überlegen, unsere Beschreibungen auch automatisiert zu verfassen und vielleicht von nicht deutschsprachigen Indern oder Pakistani als Auftragsarbeit ein paar Sätze einfügen lasse.

Hi Martin,

danke für Deine Einschätzung. Aber auch ich kann sie für meinen Teil nicht bestätigen. Trotzdem Danke ich Dir für Dein „Vorpreschen“, weil so kommen wir hier wenigstens so langsam in eine konstruktive Diskussion.

Wenn ich meine ca. 25 Kunden- bzw. eigenen Projekte miteinander vergleiche, würde ich salopp sagen: „Google hat einen Schritt in die falsche Richtung gemacht!“

Projekte, die ich nach allgemeinen SEO-Standards (generischer Linkaufbau, unique content, usw.) gut aufgebaut waren, haben an Sichtbarkeit verloren und das eine oder andere Projekt, dass eher schmal oder spammy daher kam, hat eher gewonnen.

Zumindest ist das bei ca. 70% der Projekte so zu sehen.

Ich möchte mich an der Stelle noch gar nicht aus dem Fenster lehnen und mich auf etwas festlegen. Momentan habe ich sogar noch die Hoffnung, dass Google einen Teil davon wieder rückgängig macht. Ich werde jetzt erst mal gar nicht reagieren und die nächsten 4 Wochen abwarten. Dann analysiere ich das noch mal und hoffe, die richtigen Maßnahmen treffen zu können.

Ich würde aber auch eher davon ausgehen, dass viele Bereich in dem Update berücksichtigt wurden. Die Adsense-Idee würde ich mitgehen, ich habe auch das Gefühl, dass hier ein kleiner Pinuin um die Ecke kam… DC wie gesagt gar nicht.

ich würde mich freuen, wenn wir uns hier in ein bis zwei Woche noch mal austauschen… sicherlich gibt es dann mehr Erkenntnisse.

Mal in die Runde gefragt: Welche Erfahrung haben Shopbetreiber gemacht, die ihre Ware über verschiedene Seiten verkaufen?

Wir haben bspw. laut Sistrix -15% an Sichtbarkeit mit unserem Shop verloren, allerdings verkaufen wir auch über Amazon … und im Ranking sind Amazon-Produkseiten mit unserer Ware ordentlich gestiegen.

Haben andere Multi-Channel-Anbieter in den letzten Tagen ähnliche Erfahrungen gemacht?

Das aktuelle SeoWetter deutet auf erneute gravierendere Veränderungen hin. Bin schon auf den nächsten SI gespannt.

These:

Die Wiederkehrrate wurde als Qualitätssignal aufgewertet.

Bei How-To/SEO Seiten ist sie niedrig, bei Brand-Seiten sehr hoch. Die Wiederkehrrate verifiziert die Qualität einer Webseite indirekt und ist unabhängiger vom Einfluss eines Webmasters als z.B. Absprungrate, Verweildauer etc.

Google schreibt zu „Create valuable content“

If people find your site useful and unique, they may COME BACK AGAIN or link to your content on their own websites. This can help attract more people to your site over time.

Das würde quasi das Ende kleinerer Nichenseiten bedeuten. Denn wenn ich nach Kaufberatung zu einem Backofen suche und den erfolgreich gekauft habe, sehe ich keinen Grund in den nächsten 10 Jahren zur entsprechenden Seite zurückzukehren – auch wenn ich 100%ig zufrieden war. Bietet die Seite dagegen Kaufberatung zu allen Küchengeräten, Koch-Tipps, etc. könnte sich der Nutzer denken „Die bookmarke ich mal, wer weiß wann die Spülmaschine kaputt geht“.

Hallo Martin,

vorab – toller Artikel!

Hast du schon Erkenntnisse, ob die Sichtbarkeit bei allen Artikeln auf der betroffenen Webseite zurückgegangen ist, oder betrifft der Rückgang vor allem den DC? Wie hoch schätzt du den Gewinn an Traffic durch DC ein (in Prozent) – und wie viel hast du jetzt davon verloren(mehr oder weniger)?

Christian

Interessanter Artikel Martin ,aber könntest du noch einige Beispiele nennen die deine These untermauern würden.

LG Moritz

Hi Martin,

ich habe heute festgestellt, dass ich vor allem mit URLs und Webseiten verloren habe, bei denen ich eine Menge Preseeding gemacht habe.

Beispiel:

Ich viele geile Artikel zum Thema Fußballschule. darüber kamen Links ohne Ende.

Dann haben wir die ganzen Texte unter einer geilen Landingpage zusammengeführt und natürlich die alten URLs alle 301 auf die neue URL umgeleitet.

Auf diese Art und Weise haben wir Landingpages mit Hunderten von Nischenkeywords aufgebaut und tolle Erfolge gefeiert.

Ich kann mittlerweile sehen, dass wir auf fast allen großen Landingpages, die wir so aufgebaut haben, überdurchschnittlich verloren haben. Dabei ist es egal, ob wir noch Linkbuilding (egal wie seriös) für die Landingpage betrieben haben oder nicht.

Kannst Du damit was anfangen?

Vielleicht kann ein anderer Leser etwas damit anfangen. Ich war ja sicherlich nicht der Einzige, der so vorgegangen ist.

Bei mir ist das alles sehr eindeutig und nur hier eine gewisse Regelmäßigkeit zu Tage gekommen…

Um das Problem mit dem DC elegant zu umgehen, würden sich zu einem bestimmten Thema beispielsweise 100 Spin-Texte (Uniqueness mind. 80 %) anbieten. Spin-Texte sind Texte, die durch die Verwendung von Synonymen bzw. Veränderungen im Satzbau zu umgeschrieben wurden, dass im Prinzip ein völlig anderer Artikel entsteht.

Bin schon auf das nächste Update gespannt, das für Juni angekündigt wurde. Vielleicht rankt sich danach vieles wieder in die ursprünglichen Positionen ein.

Jetzt ein paar Monate nach dem Phantom und auch dem Panda 4.2 lässt sich deutlich mehr sagen meiner Meinung nach. Der Mißfeld hatte wohl Recht mit seiner DC Theorie, da wir nie DC hatten und an Rankings gewonnen haben nach dem Phantom. Das könnte auch wiederum am Branding liegen. Ich denke es ist eine Kombination, wobei das Branding vermutlich eine größere Rolle spielt. Ich finde das auch logisch denn User wollen ja auch reltaiv häufig bekannte Seiten von „Brands“.

Die Kommentare sind geschlossen.