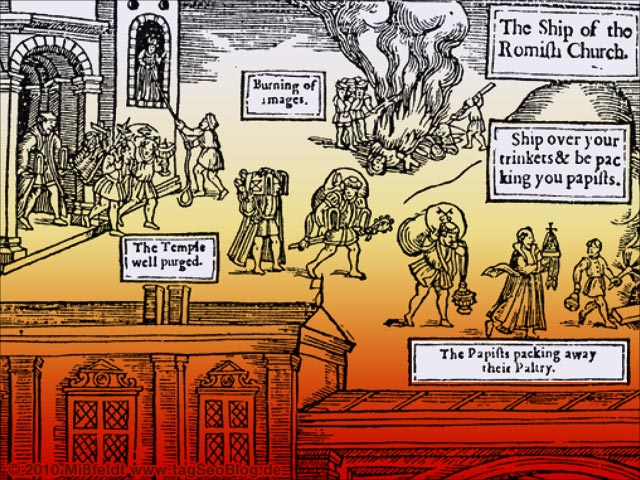

Neuer Rankingfaktor „page-speed“ – Googles Bildersturm? *Update*

Gestern hat Google wahr gemacht, was schon lange im Raum stand: die Ladegeschwindigkeit einer Webseite wird zum Rankingfaktor. Das stand zwar schon länger im Raum, aber nun sind die Details bekannt und es Realität. Zunächst nur in den USA, aber sicherlich demnächst auch in Deutschland. Offenbar wirken sich Bilder (und andere Medien) in Zukunft negativ auf das Ranking aus. Ich kann nur hoffen, dass der „Rankingfaktor Ladezeit“ nur einen minimalen Einfluss hat. Denn sonst sehe ich dramatische Veränderungen voraus: das Ende der Bilder im Internet.

Zu den Fakten: Google hat in seinem offiziellen Blog den neuen Rankingfaktor beschrieben siehe „Using site speed in web search ranking„. Ich interpretiere es so wie zum Beispiel auch Sistrix: alle Elemente einer Website wirken sich dabei aus: also Bilder, Videos, Werbung, Java-Script etc. Wer einen Google-Webmaster-Tools Account besitzt, kann die von Google ermittelte Ladegeschwindigkeit ablesen. Man öffnet dafür (links) unter „Labs“ den Punkt „Site performance“. Dort ist eine Grafik zu sehen, die die Ladegeschwindigkeit dargestellt. Auf meinen Seiten sieht die fast überall so aus:

Der „grüne Bereich“ liegt dabei unterhalb von 1,4. Alles, was länger als (1,4 Sekunden) braucht, liegt für Google im kritischen Bereich. Man sieht deutlich, dass meine Seiten deutlich im „roten“ Bereich liegen. Logisch – denn ich habe nicht eine Seite, auf der nicht mindestens ein großes Bild zu sehen wäre.

In der Konsequenz bedeutet das: Alles, was nicht reiner Text ist, wirkt sich in Zukunft negativ aus. Bilder werden also „ein negativer Rankingfaktor“. Die ideale Website ist eine, die man in den Anfängen des Internets gesehen hat: spartanisch und mit aller Gewalt auf Dateigröße optimiert. Nur: damals war es technisch bedingt – aber heute? Die Geschichte des Internets steckt noch in den Anfängen. Durch den Einsatz von Medien und die Loslösung von der absoluten Textdominanz schien sich diese Geschichte langsam weiter zu entwickeln. Aber nun will Google das Web wieder in seinen Urzustand zurückdrehen.

„Faster sites create happy users“ („Schneller Seiten machen Benutzer glücklich„), behauptet Google lapidar in seinem Posting. Ich stelle das absolut in Frage. In Zeiten von DSL ist es relativ schnuppe, ob einer Seite eine halbe Sekunde länger braucht oder nicht. Mir ist das ästhetische Erscheinungsbild und der Einsatz von Medien weitaus wichtiger. Mir scheint die Speed-Geilheit eher durch den Aktienkurs motiviert zu sein: denn natürlich können Crawler schneller und effektiver arbeiten, wenn die Seiten kleiner sind. Und vor allem: sie verbrauchen weniger Speicherplatz in Googles Serverpark. Wie so oft schiebt Google den User vor, um eigene Interessen als „Gewinn für das Netz“ zu verkaufen.

Warum sehe ich so schwarz? – Wenn man die Sache weiterdenkt, wird vermutlich folgendes passieren:

- Nach und nach werden sich die schnellsten Websites in den Suchergebnissen vorn finden

- Diese Websites bieten keine Bilder oder andere Medien

- Andere Webmaster werden ihre Bilder nach und nach raus schmeißen, wenn sie überhaupt noch gefunden werden wollen

- Wer überhaupt nicht auf Bilder verzichten mag, wird sie bis zur Unkenntlichkeit komprimieren. Die Bildqualität wird erheblich sinken.

Da Google (noch) das Haupt-Portal des Webs ist, haben Änderungen an den Ranking-Faktoren webweite Auswirkungen. Ich kann nur sagen: ein rabenschwarzen Tag für die Entwicklung des Internets. … Ok, ich gebe zu, dass ich etwas dramatisieren und überspitze. Aber in der Tendenz bin ich mir sicher: die Entscheidung von Google wird zu tiefgreifenden Veränderungen bei der Seitengestaltung führen. Große Bilder und Grafiken werden wieder verschwinden und nur durch Klicks erreichbar sein…

(btw: interessant ist natürlich, dass man konsequenterweise nun auf die „Speedbremse“ Google-Analytics verzichten sollte. Ebenso auf Adsense…)

Das schreiben andere:

- Ladezeit ist Google-Rankingfaktor – was für ein Irrweg! (Ceterum Censeo)

- Ladezeit ist offizieller Rankingfaktor (Seo-United)

- It’s Official: Google Now Counts Site Speed As A Ranking Factor (SearchEngineLand)

- SEO = Google = site speed (SEOshack)

Update

Danke für die zahlreichen Beiträge – auch in den anderen Blogs. Sehr spannendes Thema. Inzwischen sehe ich es etwas differenzierter: natürlich finde ich den Grundgedanken dahinter sehr richtig und plausibel. Es macht Sinn, Webseiten so zu entschlacken, dass sie nur noch das Notwendige enthalten. Da ist nichts gegen zu sagen. Ich verstehe nur nicht, warum die Ladezeit der Bilder da mitgerechnet wird. Es reicht doch, die Größe der HTML-Seite zu werten (inkl. CSS und serverseitigen Scripten). Bilder, Videos oder was auch immer werden doch sowieso „on the fly“ nachgeladen (wenn sie korrekt eingebettet sind). Im Grunde müsste meines Erachtens der Zeitraum von Anfang <html> bis Ende </html> gemessen werden bzw. als Faktor einfließen.

47 Gedanken zu „Neuer Rankingfaktor „page-speed“ – Googles Bildersturm? *Update*“

Ein interessanter Gedanke, ich würde mir aber nicht zu sehr Sorgen um die Bilder machen. Solange man es nicht übertreibt sollte es keine negativen Auswirkungen haben. Allerdings macht es Sinn, dass man sich technisch ein paar Gedanken macht, damit die Ladezeit von Bildern nicht zum Flaschenhals werden. YouTube ist ein schönes Beispiel dafür, wie eine Seite mit vielen Bildern trotzdem schnell laden kann. Verbesserung bei der Ladezeit erreicht man beispielsweise, wenn man die Bilder auf eine Subdomain auslagert, so dass der Browser mehr Elemente der Website parallel laden kann.

du hast absolut recht, ich finde auch, dass das ein schritt in die falsche richtung war und definitiv kein mehrwert für die user im vordergrund steht…

aber da die meisten google user mit der rosaroten brille vor dem screen sitzen und deren aussagen mit einem simplen kopfnicken schlucken werden, wird sich auch die medienwelt in die richtung „viel weniger ist mehr“ entwickeln…

außer es stellen sich alle in die quere, da ist aber in relation ein weltunterganga alla 2012 wahrscheinlicher ;-)

Hallo Martin,

ich würde das (noch) nicht so drastisch sehen. Denn so lange man bei Google wirklich noch den User in den Mittelpunkt stellen will müssen Websites mit mehr als nur reinen Text gerankt werden. Sollte sich Google wirklich so naiv anstellen und seine Vormachtstellung abgeben? Ich kann es mir nicht vorstellen.

Sehr zweifelhafte Entwicklung. Das die Ladezeit mit ins Ranking eingeht ist aus Usability Sicht ja auch vollkommen logisch, allerdings muss es wirklich aus der Sicht des Users entschieden werden. Eine halbe Sekunde Ladezeit merkt man selber ja gar nicht, 5 Sekunden schon… Da kein Mensch eine Seite sehen will die nur aus Text besteht und auch das Userverhalten wohl irgendwann mal ein „richtiger“ Rankingfaktor sein wird, gleicht sich das dann wohl wieder hoffentlich aus.

Ui, ui, ui!

So schwarz wird es wohl nicht kommen. Vielleicht sollten wir in der Diskussion „Bilder“ durch „Grafiken“ ersetzen, dann darauf kommt es an. Hintergrundgrafiken, Kacheln und Designelemente. Das man da keine Bitmaps reinhaut, ist sicher jedem klar. Die Initiative von Google zielt auf diese Strukturgrafiken im Webseitendesign.

Was schade ist, was ich auch so sehe wie du, sind schöne auflockernde Bilder in Texten, die der Übersichtlichkeit und der Strukturierung des Text dienen. Hier wird sich sicher eine Veränderung ergeben, was die Verwendung angeht.

Letztlich glaube ich aber, dass der Rankingfaktor eher so interpretiert wird, dass sich die Ladezeit einer Seite innerhalb bestimmter Durchschnittwerte befindet muss. Seiten, die zu langsam sind, erhalten schlicht den Bonus nicht. Mehr Speed wird dann aber nicht zu besserem Ranking führen, wie es bei Links der Fall ist. Einen Beweis für diese Theorie habe ich nicht, würde das aber aus Google Sicht für schlüssig halten.

Ich bin mir ziemlich sicher, das Seiten mit vielen externen (oder auch interne) Banner, große Probleme bekommen werden. Da werden sich einige Leute richtig was einfallen lassen müssen. Möglicherweise bricht da sogar ein ganzer Markt weg.

Ansonsten denke ich, sind 1-2 Thumbnails, welche auf Original Größe Zoombar sind (und somit nachträglich geladen werden), kein Hindernis für eine ordentliche Ladezeit.

Ich finde den Schritt durchaus gut, hab selber auch schon länger darauf hingearbeitet. Ich denke nicht das es wirklich so argen Einfluss auf das Ranking haben wird, ich denke eher, es gibt gewisse Grenzwerte ab denen das Ranking fällt. Ich mag auch keine Seiten in den Suchergebnisse wo man dann erstmal einkaufen gehen kann bis die Seite geladen ist.

Moin moin,

sicherlich ist das ganze im Moment etwas ärgerlich, trotzdem würde ich das auf lange Sicht nich ganz so verbissen sehen, keiner wäre doch so dumm den Ast abzusägen auf dem er sitzt (Ausnahmen bestätigen die Regel).Die Entwicklung sollte doch immer in Richtung „noch schneller,noch besser“ gehen, das ist ja nunmal in der Natur des Menschen verankert, der Weg dahin sollte eben nur nicht allzu holprig sein. Sollte das angestrebte Ziel auf email Niveau sinken, werden auch die Besucherzahlen rapide fallen, das wiederum sollte doch zum Nachdenken veranlassen. Es geht doch ständig auf und ab im Leben, nehemen wirs gelassen, vielleicht reicht es auch eines Tages, und man schmeist den ganzen Elektronikkram aus dem Fenster und geht einfach angeln, dann hat sichs ausgegoogelt ;-))

man sollte das ganze vielleicht mal folgendermaßen sehen:

Das Ziel von Google (und allen anderen Suchmaschinen) ist es, dem Benutzer zu geben, wonach er sucht. Sollte dies nicht mehr der Fall sein, verliert Google seine Position im Suchmaschinenranking :-)

Daher kann Google relativ langsame, aber qualitativ hochwertige Seiten nicht schlechter ranken. Ich denke das sich dieser Rankingfaktor nur in Extremfällen oder bei qualitativ minderwertigen Seiten auswirkt.

Die Situation ist für mich ungefähr mit der Problematik verkaufter Links gleichsetzen. Google will neben den Käufern auch die Verkäufer bestrafen, kann sich aber keine Herabsetzung des Rankings der entsprechenden Seiten erlauben, da diese ja trotzdem für den Besucher interessanten Content zum Abruf bereit halten…

Du schreibst „In Zeiten von DSL ist es relativ schnuppe, ob einer Seite eine halbe Sekunde länger braucht oder nicht.“. Eine halbe Sekunde ist eine halbe Sekunde – egal, wie viele Daten in dieser Zeit durchrauschen.

Es ist ein wenig anders: In Zeiten von DSL kann ich Seiten bauen, die 500 MB groß sind und trotzdem in einer Sekunde beim User sind. Und ich finde, in 500 MB passen eine Menge Bilder rein.

Ich muss das halt schnell ausliefern. Und meiner Ansicht nach zielt Google damit mehr auf schlecht gehostete und mies gebastelte Javascript-CMS-Katastrophenseiten als auf gute Bilder, die ja statisch vorliegen und deshalb kaum Zeit benötigen.

Ich schätze mal, dass auch deine Startseite länger in der Datenbank nachdenkt, als sich mit dem Ausliefern von Daten zu beschäftigen. Und das kann man immer beschleunigen – ohne Verlunst von attraktiven Inhalten.

Finde ich jedenfalls ;-)

grüße

eric

Hmm, also zumindest kann nicht das für das Ranking herangezogen werden, was in den Webmastertools unter „Site performance“ angezeigt wird. Das dient bestenfalls zur groben Orientierung für den Webmaster.

„Die Ladezeit einer Seite ist die Gesamtzeit ab dem Zeitpunkt, an dem ein Nutzer auf einen Link zu Ihrer Seite klickt, bis zu dem Zeitpunkt, an dem die gesamte Seite geladen wurde und in einem Browser angezeigt wird. Diese Informationen werden direkt bei Nutzern abgerufen, die die Google Toolbar installiert und die PageRank-Funktion aktiviert haben.“

Vielleicht sieht die Kurve bei Martin ja nur so schlecht aus, weil er viele Leser mit einer langsamen Internetverbindung (wie z.B. mich) hat. :-)

Aber ich habe keine Google Toolbar, damit sind meine Speedwert sowieso nicht relevant.

@eric

Dein Beispiel ist etwas fehlerhaft. Mit einer DSL Leitung bekommt man keine 500 MByte, sondern nur etwa 500 KByte (bei DSL 5000) in einer Sekunde durch die Leitung und dann hinkt das Beispiel etwas. 500 KByte reichen für etwa drei mittelgroße (800 x 600 pixel) Bilder.

Allein umfangreiche JavaScript oder CSS Dateien, die häufig mit Frameworks oder Templates ausgeliefert werden, umfassen schon jeweils über 100 KByte…

Ich würde annehmen, dass ihr einem Denkfehler aufsitzt. Google wird nicht eine Text-Seite mit einer Video-Seite vergleichen und dann die mit dem Video abwerten, weil sie zu langsam ist. Die Ladezeit wird in Abhängigkeit der Größe der Seite gewertet werden. Eine Bilder-Seite der Größe 500Kb wird abgewertet, wenn sie bei DSL länger als 10 Sekunden braucht. Eine Textseite mit 3Kb wird abgewertet, wenn sie länger als eine Sekunde braucht(nur als Beispiel). Es fließt also Größe/Ladezeit ein und nicht die pure Ladezeit. Also malt mal nicht so schwarz.

@Putzlowitsch, ich hatte gerade einen Contra-Kommentar zum Blogartikel geschrieben, da ich bisher davon ausging, dass dieser Wert vom Googlebot selbst gemessen wird und deshalb integrierte Bilder, Skripte etc. überhaupt keine Rolle spielen, da sie sich allenfalls durch die paar Bytes des „img src … /“-Tags bemerkbar machen.

Dass diese Dauer über die Toolbar ermittelt wird, war mir völlig neu.

Meinen Kontra-Kommentar habe ich gelöscht, jetzt bin ich erstaunt und will keine Behauptungen aufstellen. So oder so denke ich, die Auswirkungen sind nicht drastisch – einer von hunderten Ranking-Faktoren, der wohl kein übermäßiges Gewicht bekommen dürfte.

Das man Google-Analytics entfernen soll, den Tip bekommt man von den Webmastertools ja schon länger angezeigt.

Google ist da zumindest objektiv, dass man auch auf Adsense verzichten soll erscheint allerdings nicht.

In Zeiten von DSL surfen aber auch viele unterwegs mit UMTS oder noch langsameren Verbindungen.

Solange die Geschwindigkeit einer von 200 Rankingfaktoren ist, heißt das ja noch lange nicht, dass Grafiklastige Seiten nicht mehr auf die vorderen Plätze kommen können. Es ist eben ein Faktor.

na ja das ende der bilder wird es wohl nicht sein. es gab vor zehn jahren so viele „unumstößliche“ gesetze, da war die ladezeit nur eine. man denke mal an die durchsuchbarkeit von dynamischen seiten…

wenn man sich an solche „gesetze“ hält, stößt man irgendwann an grenzen.

Jep. Hatte ich auch schon bei den Jungs von SEO United gelesen. Bin mal gespannt, wie das weiter gehen wird .. mit G … und den RF

Cya

Seba

Hi Martin, ich sehe es ähnlich wie Du allerdings auch nicht ganz so dramatisch. Folgende Gründe habe ich dafür. Zum ersten wird in der Tabelle mit den 1,4 sek. vielleicht auch eine Art Puffer gelpant und es dient uns als Ziel. Zum zweiten spricht nichts dagegen die Seiten nach wie vor weiter für den User zu optimieren, d. h. unter anderem die Seiten zu entschlacken und die relevanten Themen und Inhalte auf der Seite anzubieten. Ich denke relevante Bilder werden nach wie vor als positiv gewertet. Es geht eher darum aus drei Themen auf einer Seite, drei Seiten mit drei relevanten Themen darzustellen. Die Zahlen sind jetzt mal fiktiv und erdacht, bei vielen Seiten trifft das aber sicherlich noch zu und man sieht sehr oft den großen Gemüsegarten.. Da derzeit auch immer mehr mobil suchen müssen sich die Seiten natrülich schneller laden.. das ist Zukunft, die lässt sich nicht aufhalten. Reine Textseiten sind damit aber sicherlich nicht gemeint, sondern relevante und technisch optimale Seiten. Eine reine Textseite will sicher auch kein User sehen.. die Absprungrate möchte sich auch keiner antun. Und sicher möchte man aufgrund der schnellen Auslieferung von „textseiten“ in den Scuhergebenissen Zielgruppen und Nutzer „nicht“ an die Wettbewerber abgeben.., das würde nämlich ganz sicher passieren… es würde doch kein schöner und relevanter shop mehr auf pos. 1 – 30 stehen.. etc etc.. daher. Technisch optimeren und mit sicherheit auf der Seite relevant bleiben mit allem was nötig ist. Visibility und Usability ist nach wie vor wichtig. Einfach das nötige tun und weiter beobachten. Best Tom

Ich bin grade dran meine Webseite „schöner“ und schneller zu machen.

Bei seitenreport.de wird einiges analysiert, unter andern auch die Ladegeschwindigkeit, Größe der html, css-Dateien, Größe der Bilder und Flashobjekte.

Ich versuche einfach die Bewertungen auf 100% zu bekommen und bin dann zufrieden.

Auf der anderen Seite, wenn alle wieder abspringen, weil die Seite nicht schön aussieht, bringt die Optimierung gar nichts.

Schnell und schön so mnuss es sein.

Wie der Spruch denn ich seit Jugend an eingetrichtert bekommen habe: „Arbeite schnell und sorgfältig“.

So ist es bei der Webseite nun auch: Lade schnell mit guter Qualität.

Das sind aber schlechte Aussichten für mich als Fotograf. Meine Seite lebt davon, das ich Bilder zeige – reiner Text für eine Fotografenseite – das geht doch gar nicht. Eventuell muß ich auf einen schnelleren Server umziehen – das kostet aber wieder viel Geld – und das empfinde ich als ungerecht!

@Alexander: Ja für Bilderlastige Webseiten ist das keine gute Nachricht, aber auch hier gibt es viele Möglichkeiten die Geschwindigkeit zu verbessern. Die kosten natürlich auch ein bisschen was, aber die Besucher werde es dir ebenfalls Danken!

Hi Alex, mach es doch wie onassis… der Gedanke ist doch auf jeden Fall richtig. Darüber hinaus werden Deine Wettbewerber doch ebenfalls viele Bilder anbieten – Du musst halt zumindest besser sein als die in der Technik würde ich sagen… das klappt scho, Du musst Dich ja mit deinen Wettbewerbern messen. best tom

Hat denn irgendjemand schon eine Vorstellung, welche Gewichtung dieser Ranking-Faktor hat?

(Der Server-Standort ist doch auch ein Ranking-Faktor, trotzdem denkt keiner allzu sehr darüber nach…)

Meine Google Webmaster Analyse sieht nicht viel besser aus, für alle Blogs :-( Bedeutet dies dass man mit einem normalen, leistbaren Shared Webspace in Zukunft nicht mehr weiterkommt, sondern sich immer gleich einen Server mieten muss? Aus Usersicht kann ich das Ranking Kriterium schon verstehen, aber hat man da als kleiner Blogger noch Chancen?

Ganz so schwarz wird`s mit den Bildern ja doch nicht kommen. Natürlich empfiehlt es sich, die Bilder vom Speicherbedarf her zu reduzieren. Das macht aber doch sowieso jeder. Wie lange dieser Rankingfaktor bleibt und ob nach einiger Zeit nicht doch wieder von G. zurückgerudert wird, stellt sich erst in einigen Monaten heraus. Jetzt schon Konsequenzen zu ziehen, wäre meiner Meinung nach doch zu voreilig.

Das war mir eigentlich schon klar, dass dies mal ein Rankingfaktor wird. Denn ein User will ja auch, dass eine Seite schnell läd, darum muss Google das auch beachten.

Ich begrüße diese Initiative von Google sehr. Das Web 2.0 hat uns nicht unbedingt eine besseres Internet gebracht. Das was heute an unnützen Bildern, Flsh’s, Videos und sonstigen Firlefanz auf vielen Seiten begegnet hat rein garnichts mit unserer Informations-Gesellschaft zu tun. Weniger Schnickschnack und mehr Content tut dem Web doch nur gut.

Ich finde das Thema recht „über-diskutiert“.. Ich denke, dass es nicht darum geht, eine Seite mit einer Sekunde Ladezeit einer Seite mit 2 Sekunden vorzuziehen, sondern die Seiten mit 15+ Sekunden auf die hinteren Plätze zu verbannen, denn diese sind sowieso nicht gut für den Besucher. Ich persönlich warte nicht länger als 10 Sekunden, bis ich auf der Seite was sehe…

Des Weiteren glaube ich nicht, dass bilderlastige Seiten (Galerien, Photo-Seiten, ..) zurückfallen, denn die Konkurrenz wird im diesen Falle wohl auch bilderlastig sein.

Ich finde dieses Verhalten Von Google auch völlig am Thema vorbei. Ich habe eine Seite, welche Bilder benötigt, damit die Leute sehen, wie bestimmte Dinge aussehen. Für einen Reiseführer sind Bilder ja auch lebensnotwendig. 300 x 225 Pixel haben die größten Fotos und kleinere Bilder will ich keinem Besucher zumuten, denn man muss ja noch etwas drauf erkennen. Noch zählt meine Seite zu den schnellsten 10 Prozent, naja da bin ich ja mal gespannt wie lange noch …

Guter Beitrag.

Adocom

Danke für den Beitrag.

Da bei Google die Bildersuche eine sehr große Rolle spielt, kann ich mir absolut nicht vorstellen, dass bei Bildern die Ladezeit negativ bewertet wird.

Ein schlanker und valider Code wird da eher in die Bewertung einfließen.

Hannelore

Die Kommentare sind geschlossen.